MakeHub.ai

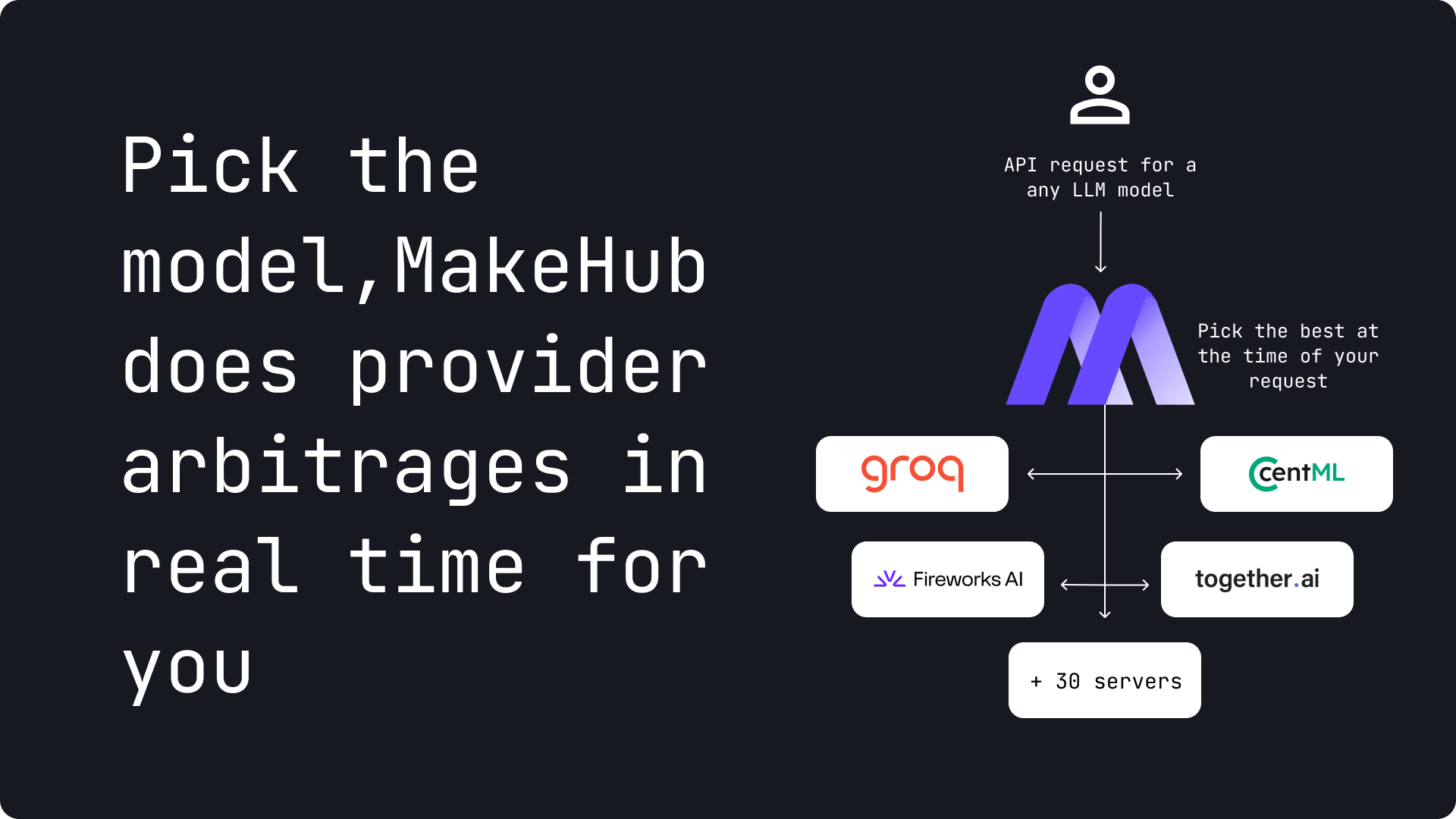

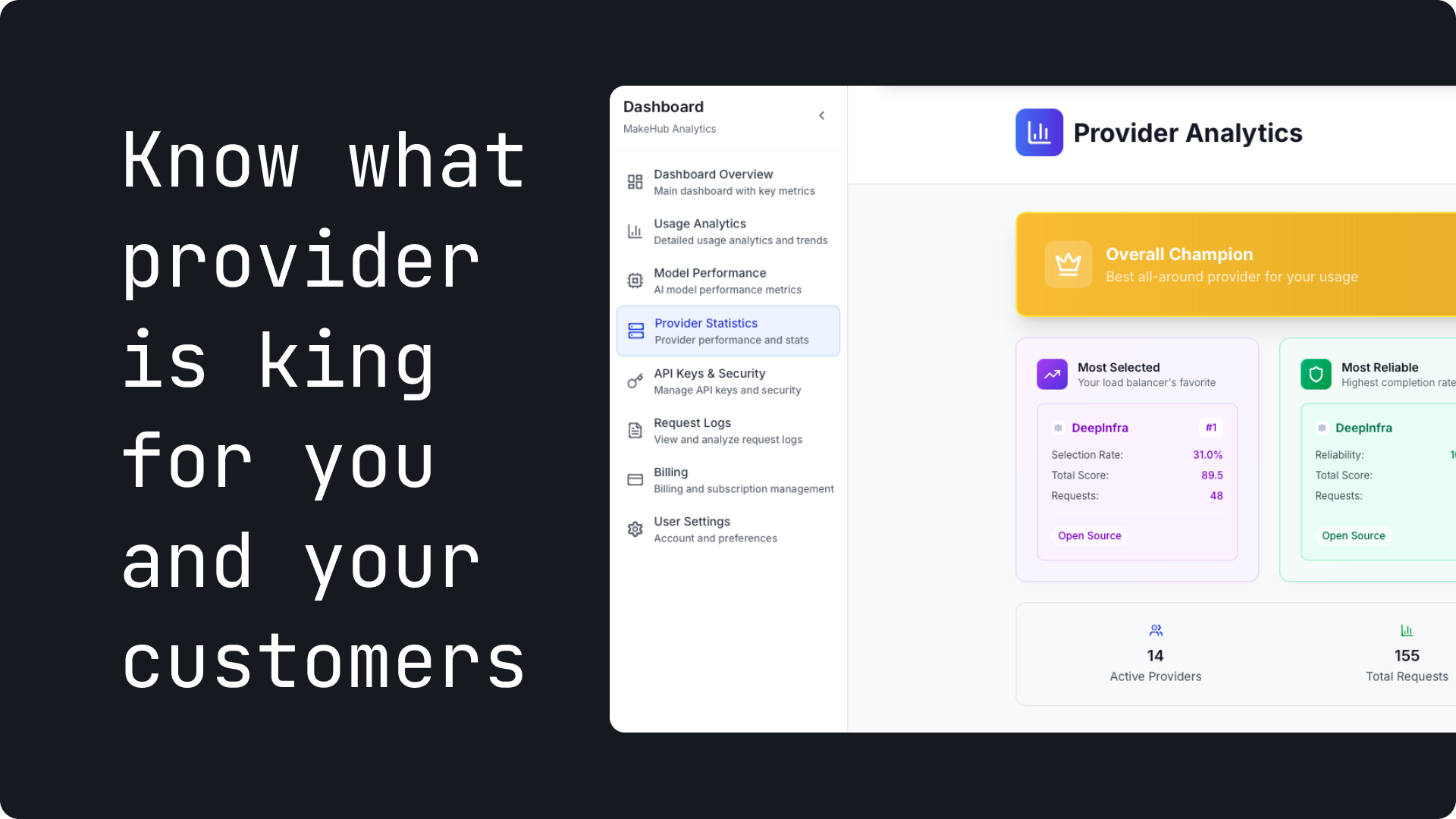

Arbitragem do provedor LLM para obter o melhor desempenho para o $

Destaque

128 Votos

Tendência

238 Visualizações

Descrição

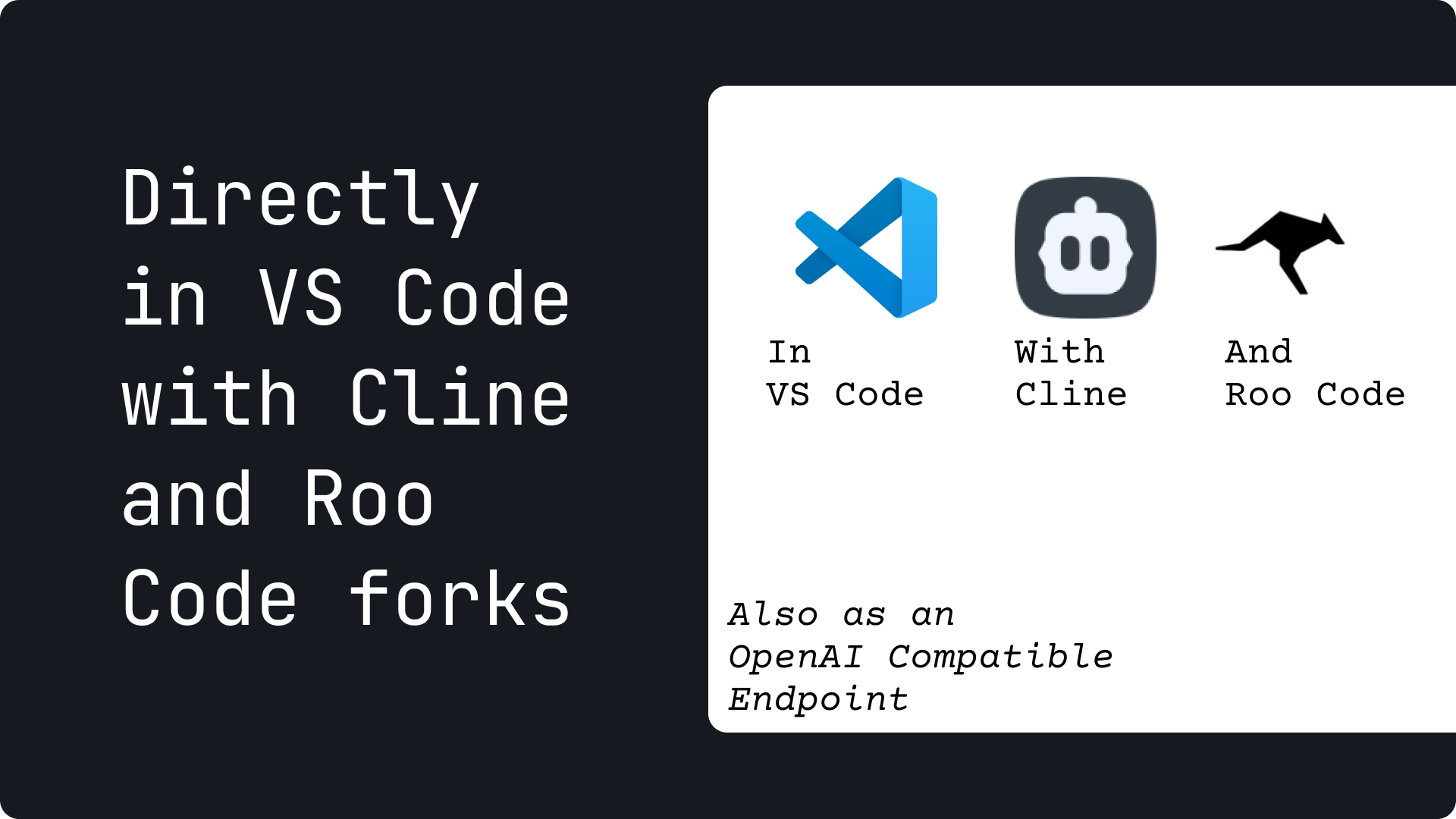

Ponto de extremidade compatível com o OpenAI.API única, rotas para o fornecedor mais barato e mais rápido para cada modelo.Funciona com LLMs fechados e abertos.Os benchmarks em tempo real (preço, latência, carga) são executados em segundo plano.Direclty utilizável agora em Roo e Cline Forks