Ler

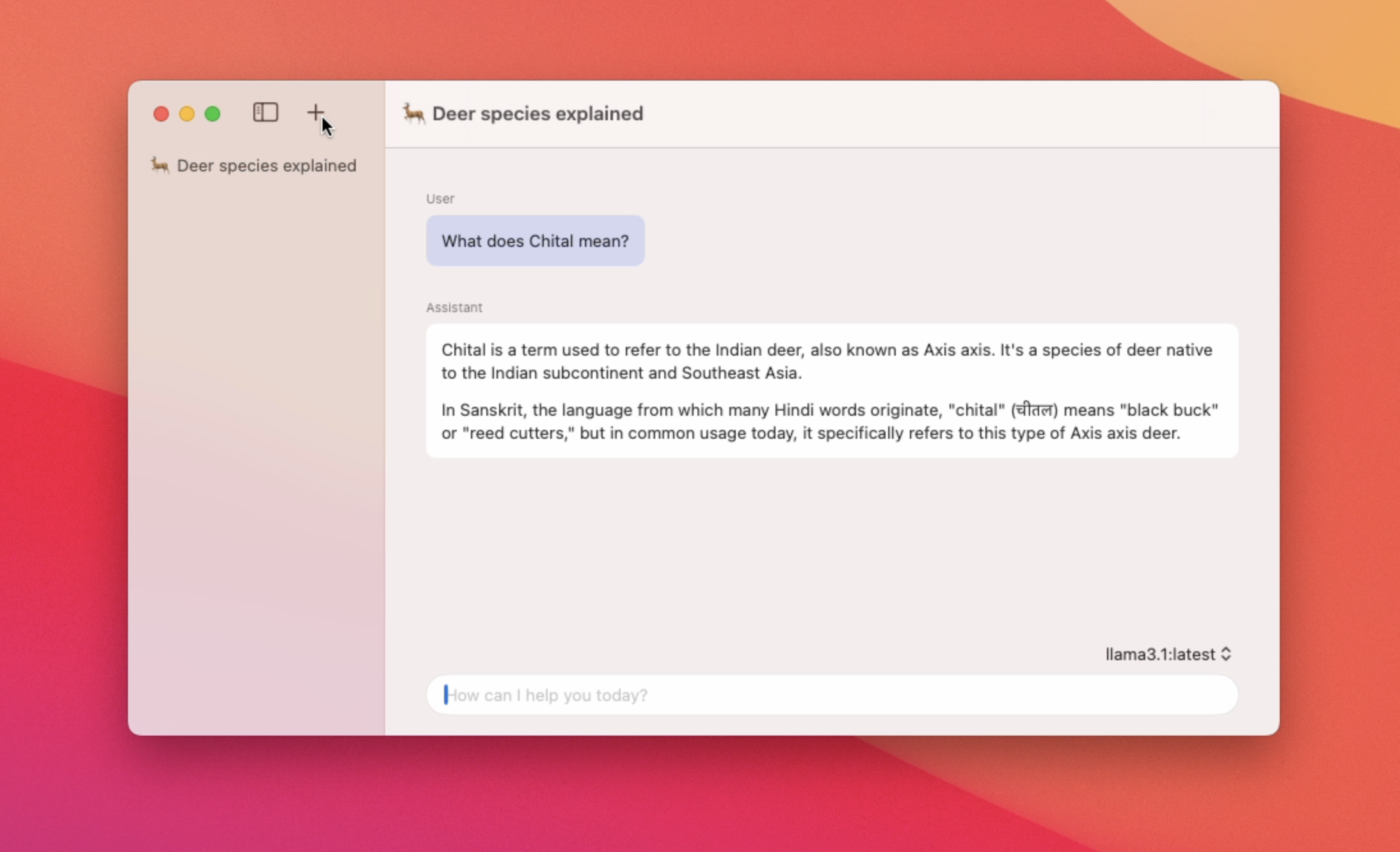

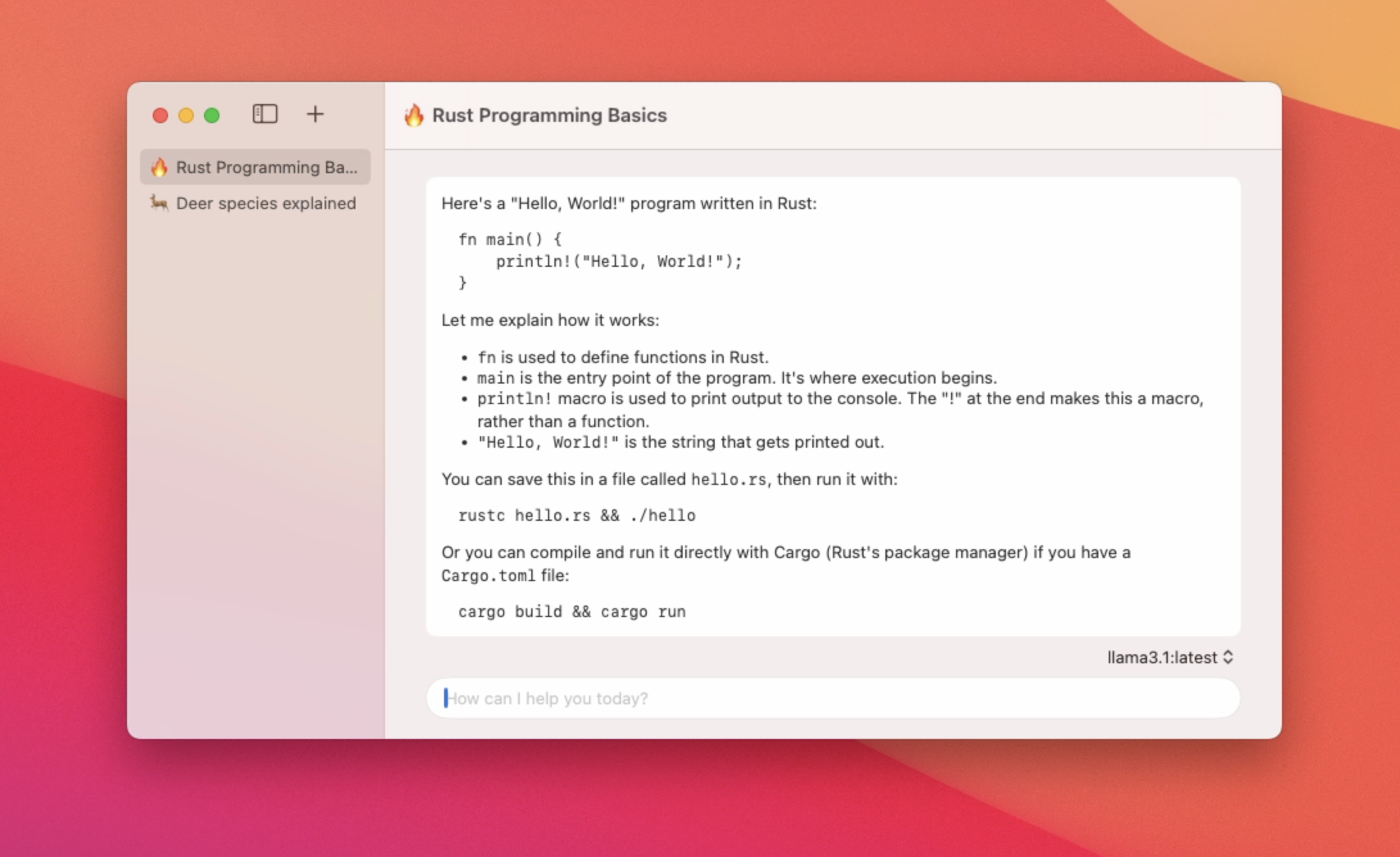

Aplicativo nativo macOS para usar LLMs locais

Destaque

6 Votos

Descrição

Um aplicativo nativo do MacOS para conversar com os recursos de modelos Ollama - Uso de baixa memória e tempo de lançamento rápido de aplicativos - Suporte para vários threads de bate -papo - alternar entre diferentes modelos - Suporte a marcação - Resumo do título de bate -papo automático