Lezen

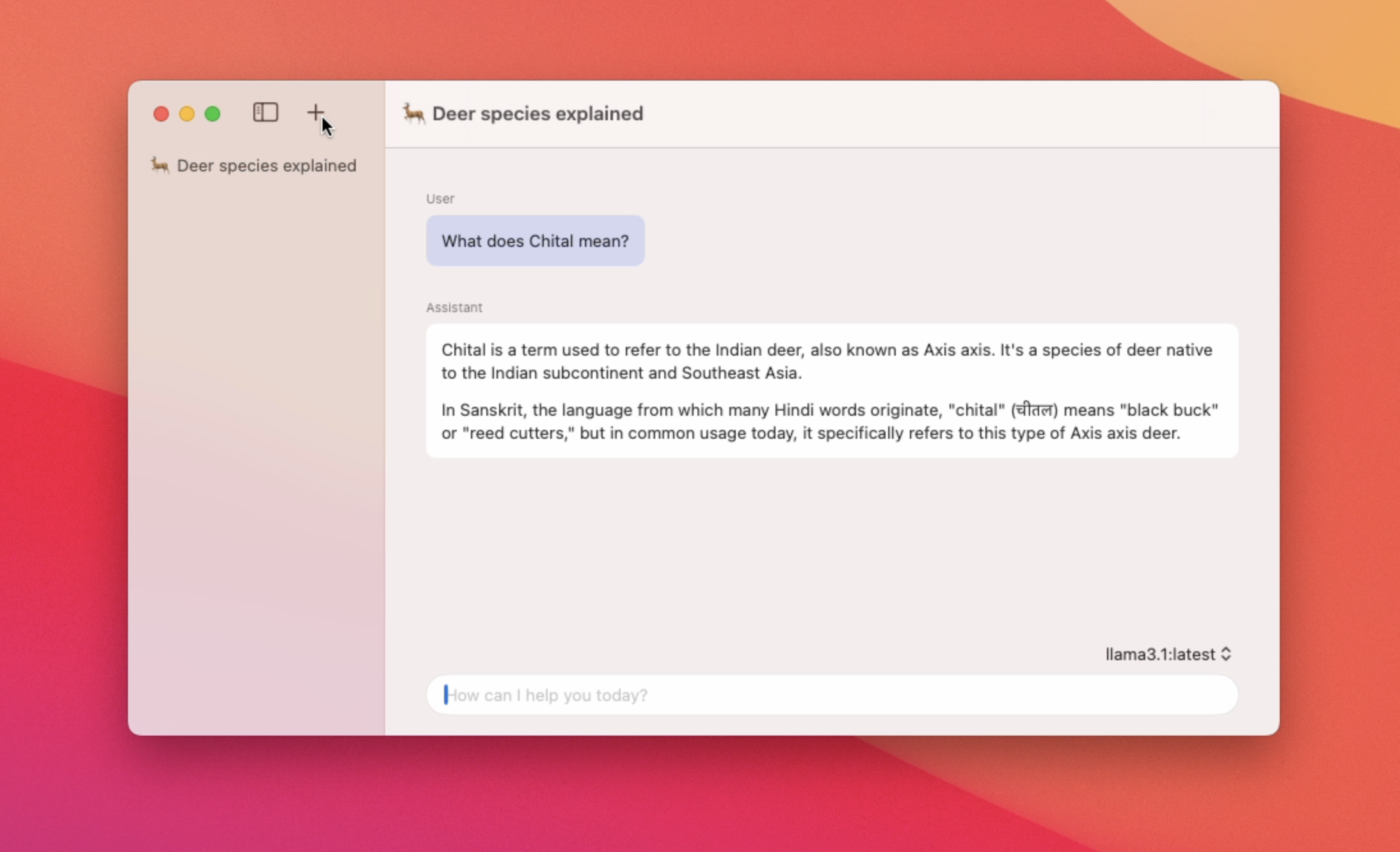

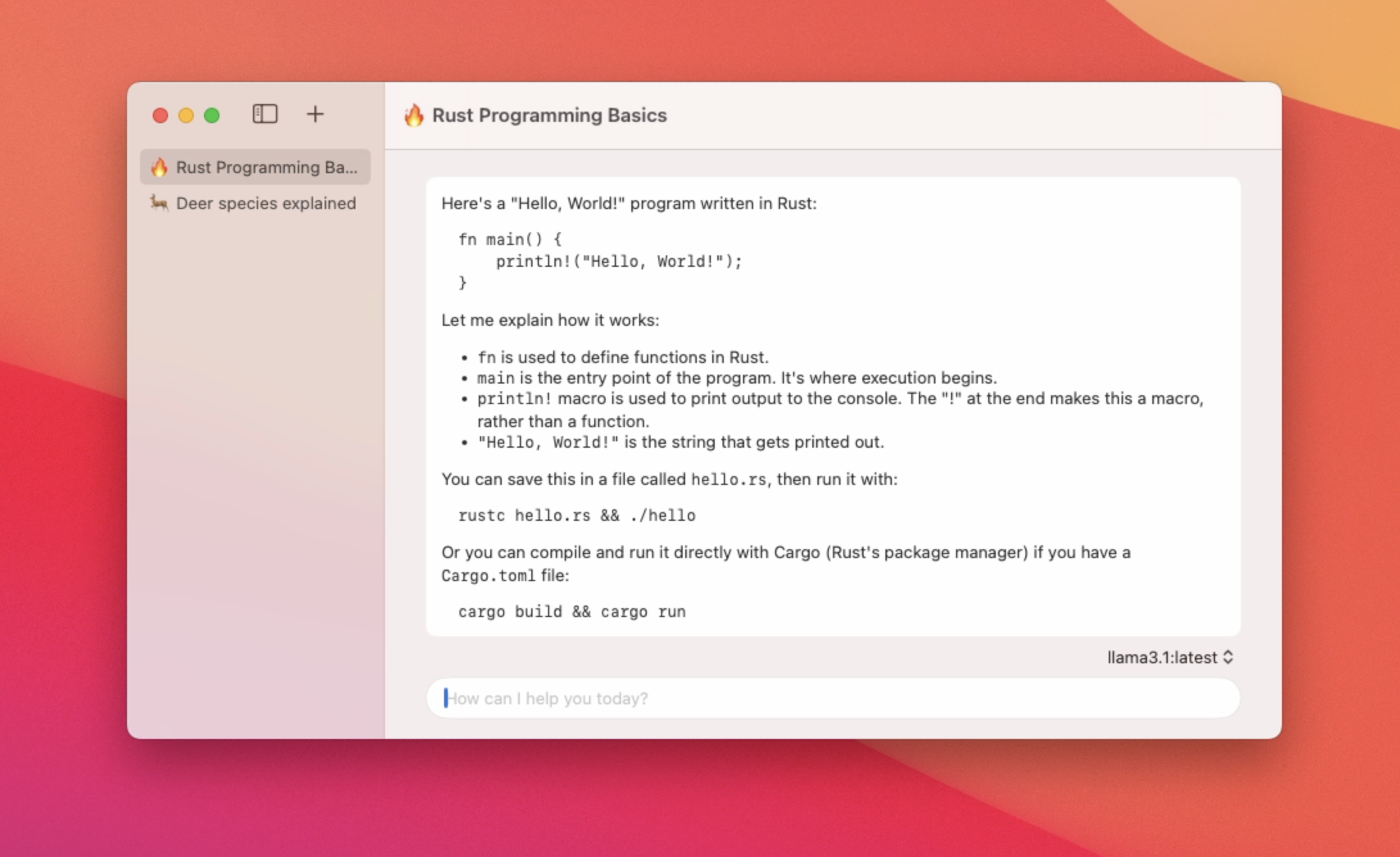

Native macOS -app voor het gebruik van lokale LLMS

Uitgelicht

6 Stemmen

Beschrijving

Een native macOS -app voor chatten met Ollama Models Functies - Laag geheugengebruik en snelle app -lanceringstijden - Ondersteuning voor meerdere chatthreads - Schakel tussen verschillende modellen - Markdown -ondersteuning - Automatische chat thread titel Samenvatting