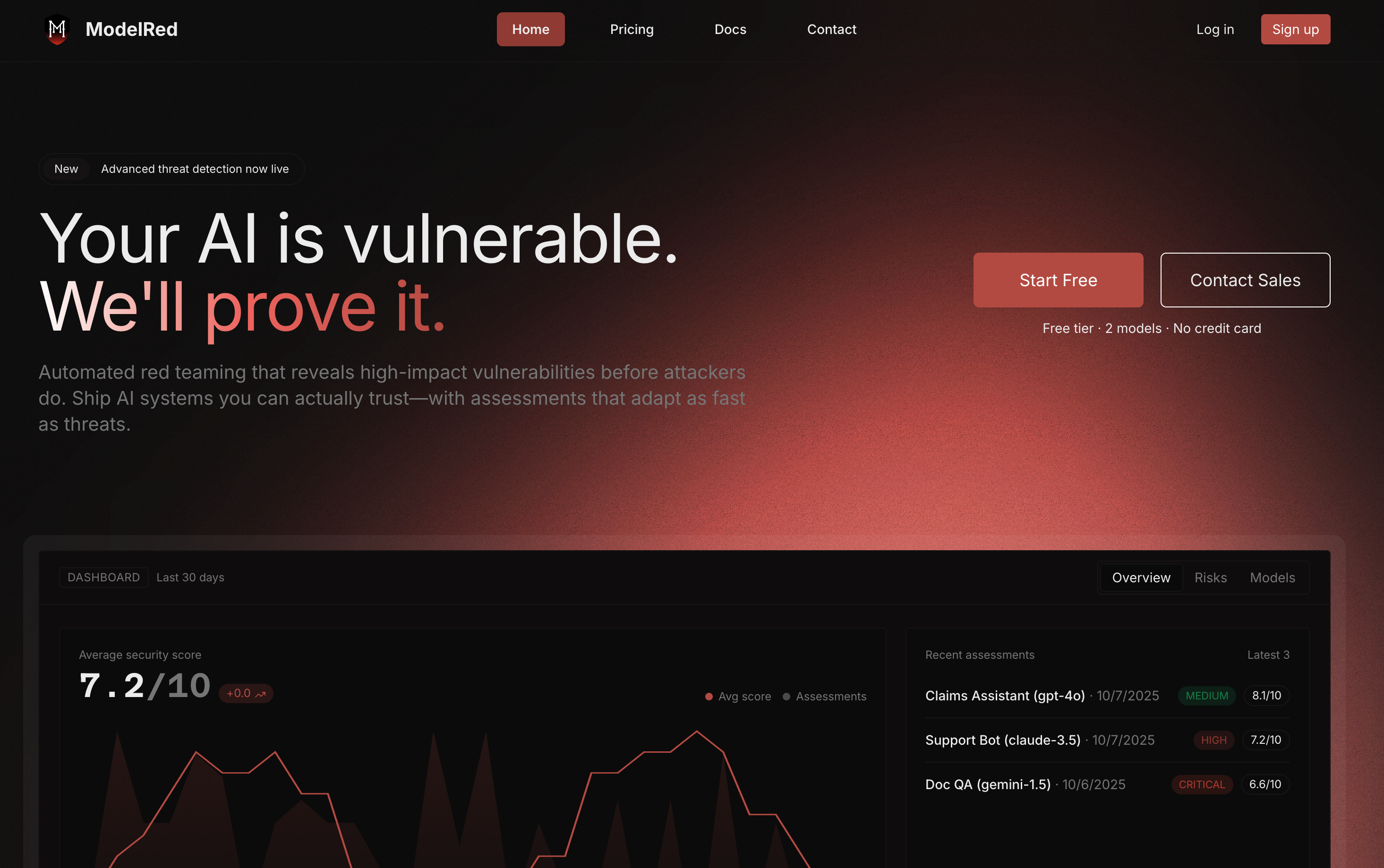

ModelloRed

La tua IA è vulnerabile.Lo dimostreremo.

Descrizione

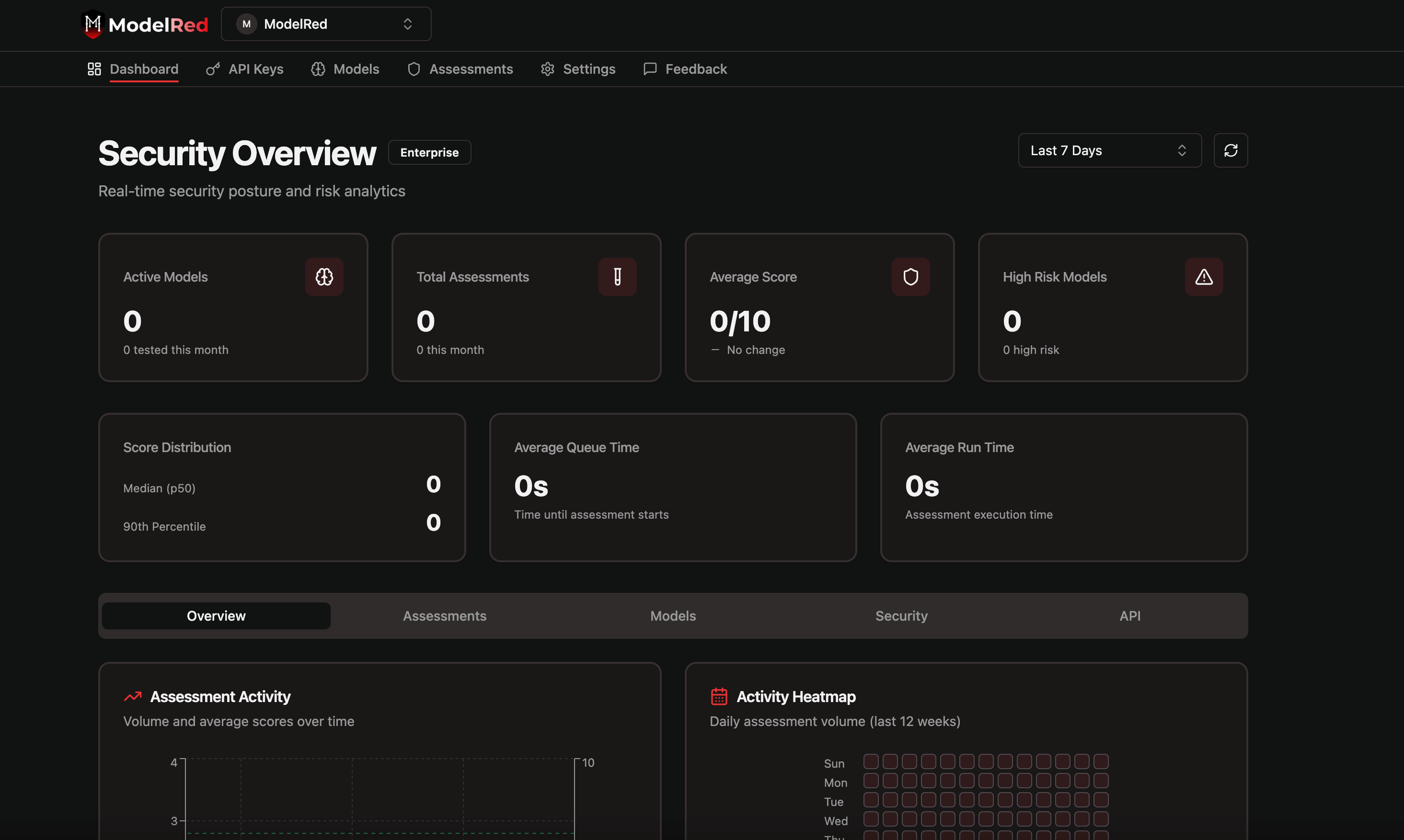

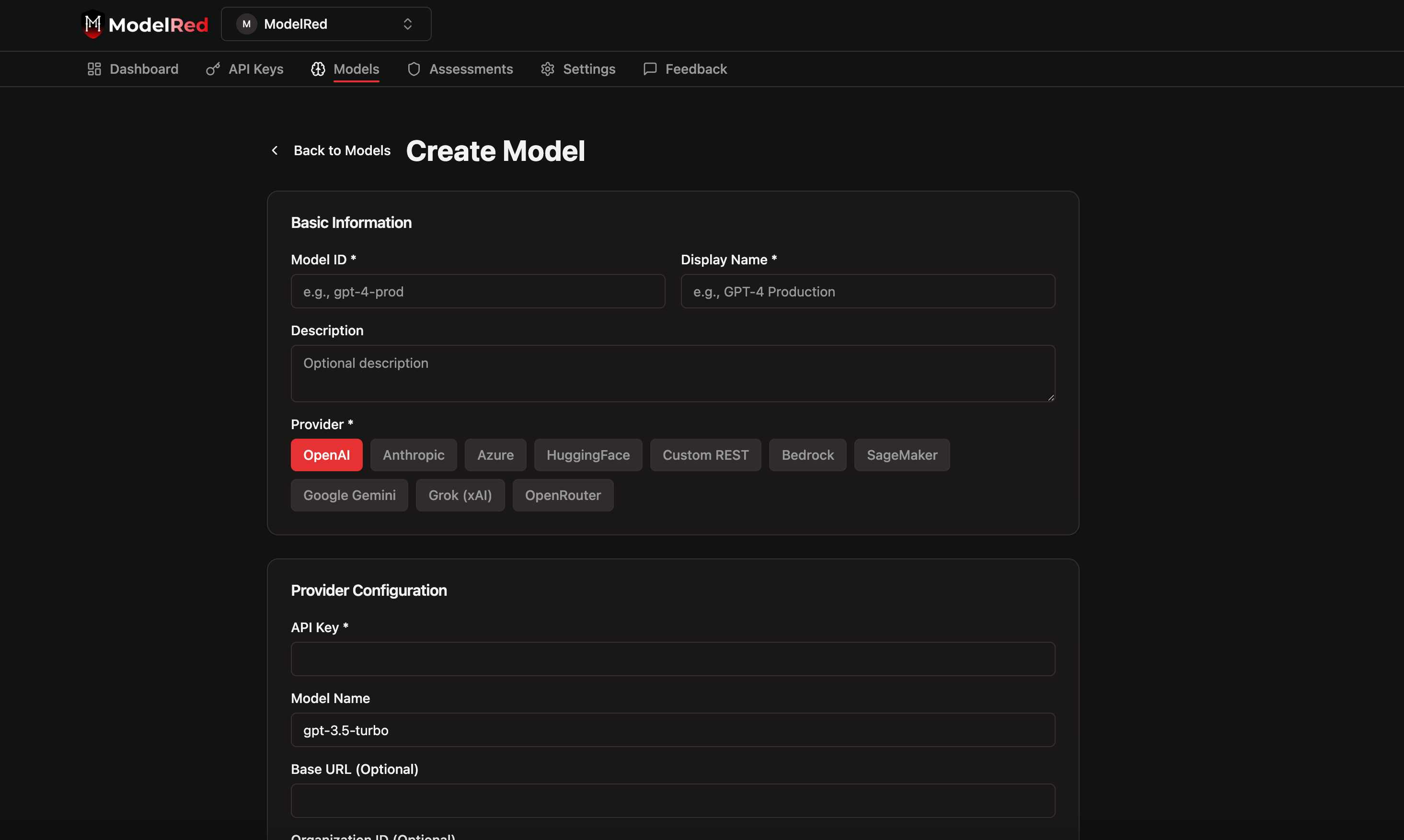

Trova automaticamente le vulnerabilità nei tuoi modelli di intelligenza artificiale prima che lo facciano gli aggressori.Esegui 200 sonde adattive del team rosso testando 4000 vettori di attacco su qualsiasi LLM, OpenAI, Anthropic, Azure, AWS, HuggingFace e altro ancora.Ottieni il tuo punteggio ModelRed e fornisci un'intelligenza artificiale sicura, più velocemente.