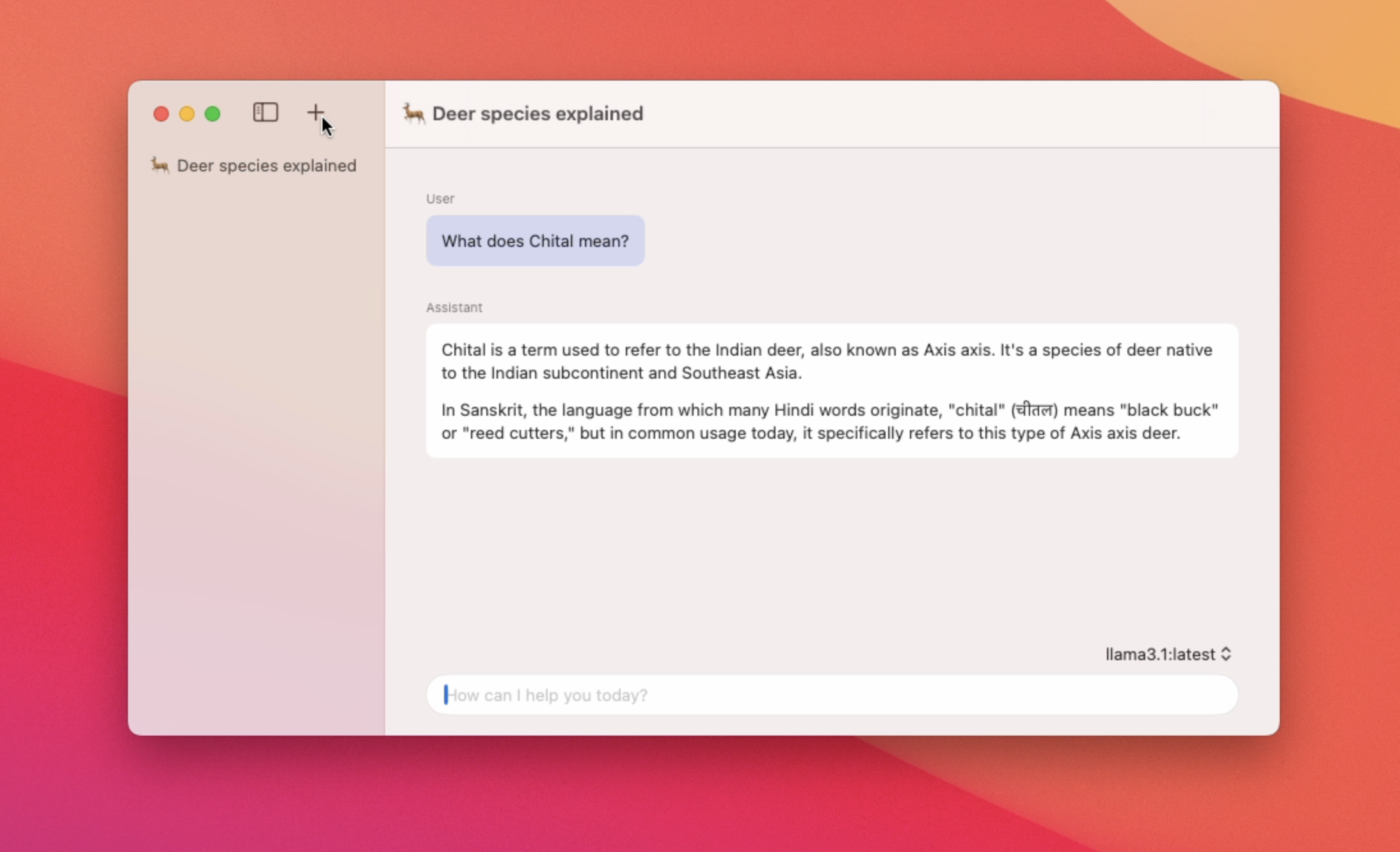

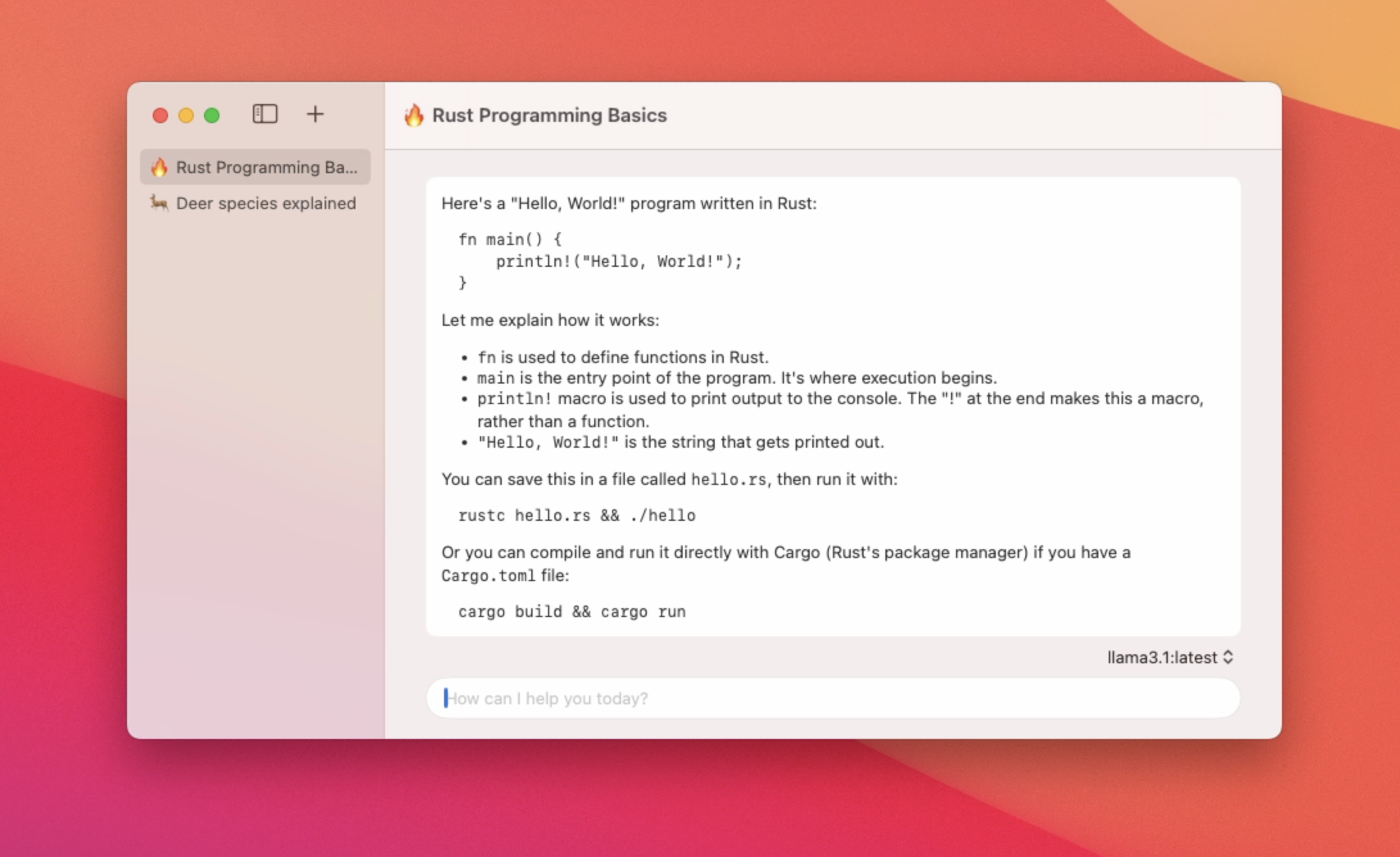

Leggere

App macOS nativa per l'utilizzo di LLM locali

In Evidenza

6 Voti

Descrizione

Un'app MACOS nativa per chattare con i modelli di ollama - Utilizzo a basso contenuto di memoria e tempi di lancio dell'app Fast - Supporto per più thread di chat - Passa tra i diversi modelli - Supporto Markdown - Riepilogo del titolo del thread di chat automatico