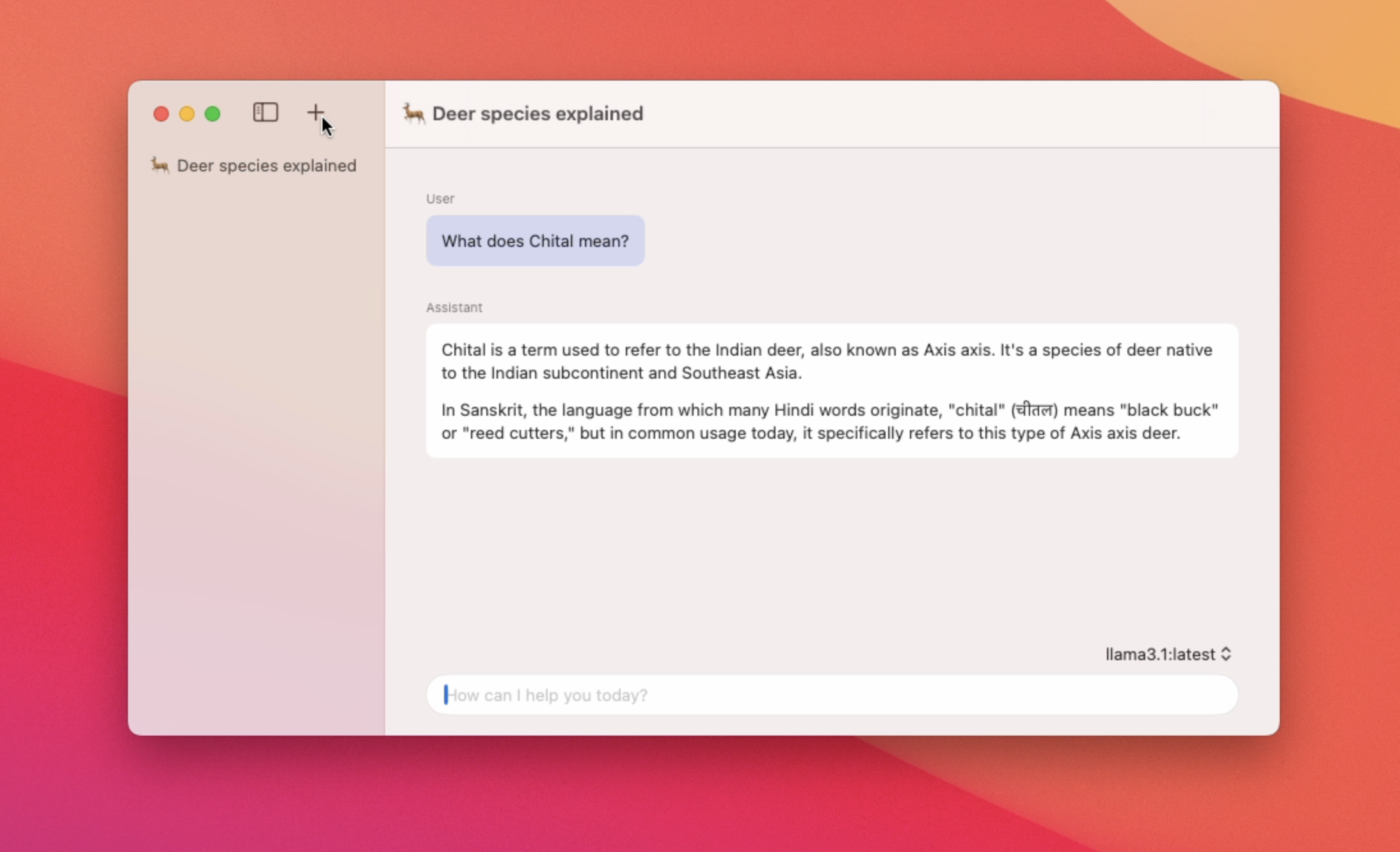

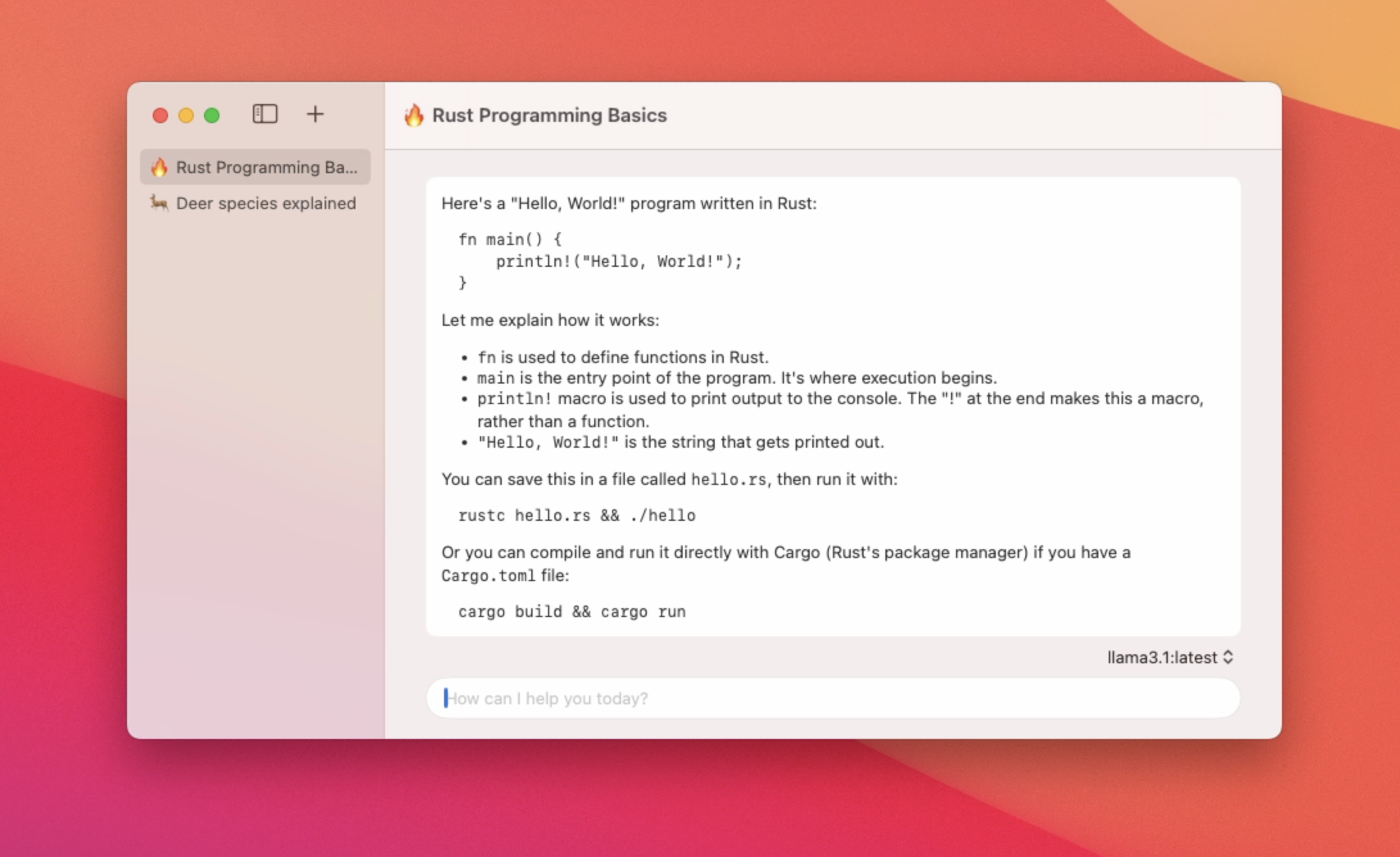

Lire

Application macOS native pour l'utilisation des LLM locales

En vedette

6 Votes

Description

Une application macOS native pour discuter avec les fonctionnalités des modèles Olllama - Utilisation de la mémoire basse et temps de lancement rapide des applications - Prise en charge de plusieurs threads de chat - basculez entre les différents modèles - support Markdown - Résumé du titre du thread de chat Automatique