Leer

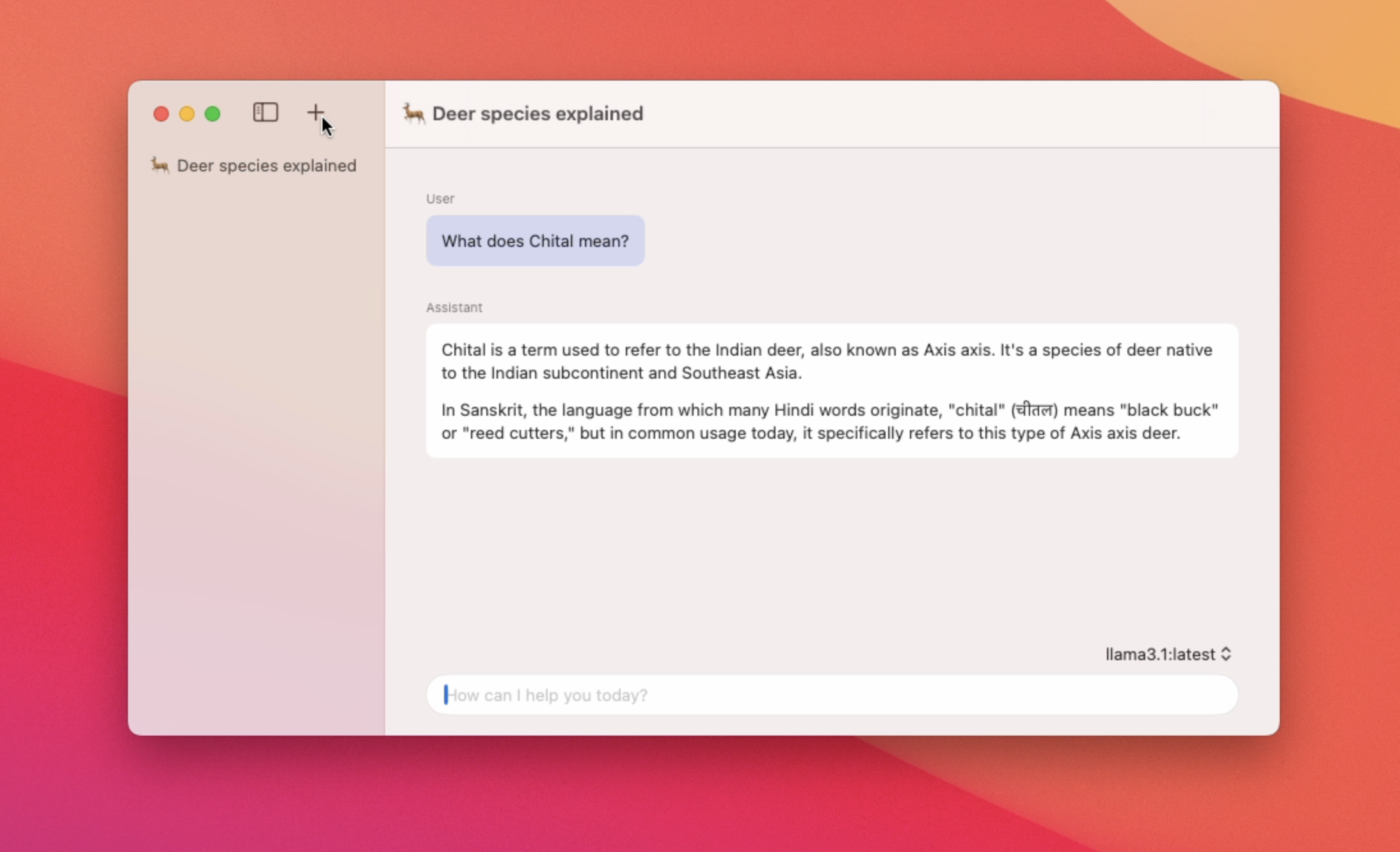

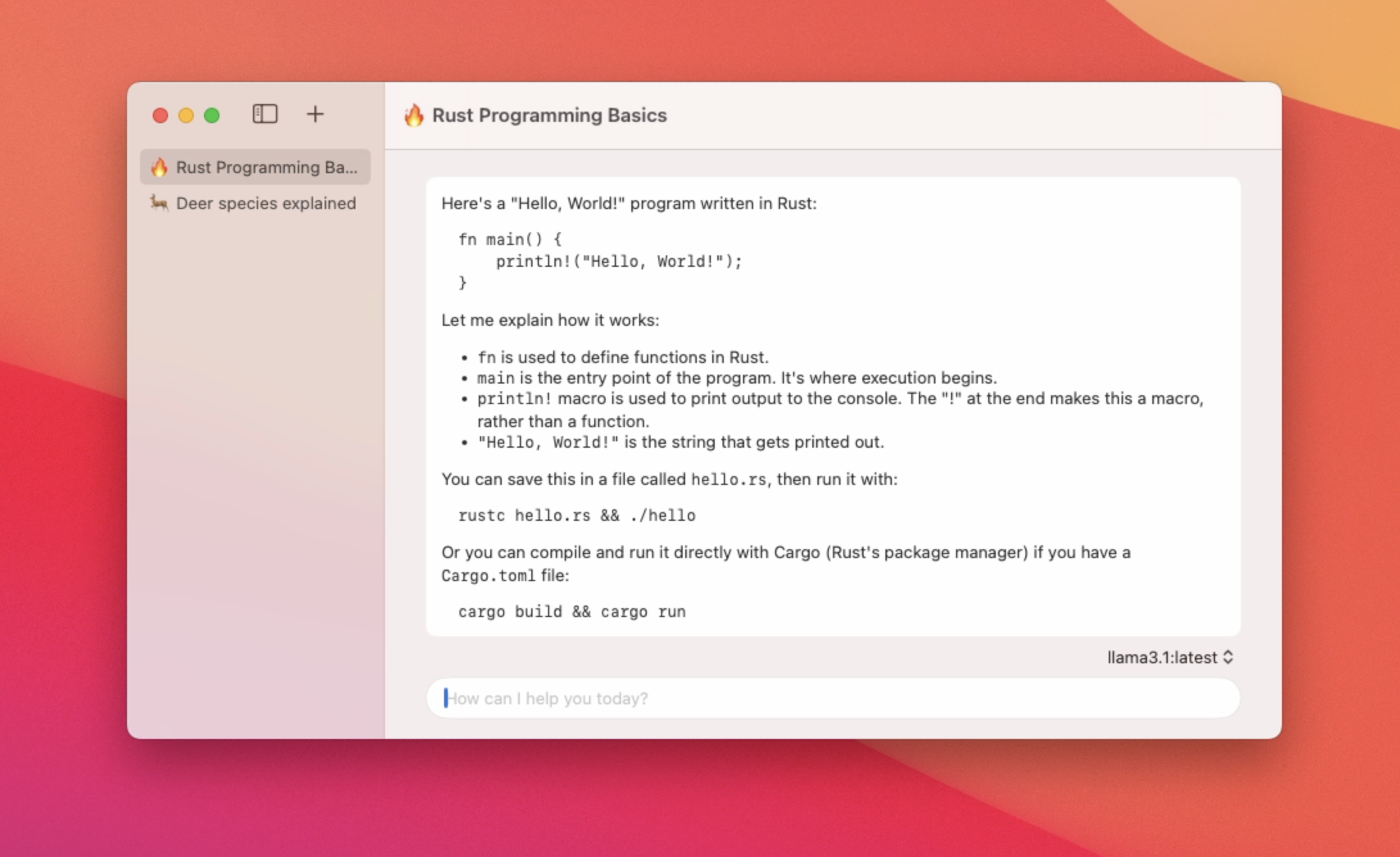

Aplicación nativa de macOS para usar LLM locales

Destacado

6 Votos

Descripción

Una aplicación Native MacOS para chatear con las características de los modelos Ollama - Uso de baja memoria y tiempos de lanzamiento de aplicaciones rápidas - Soporte para múltiples hilos de chat - Switch entre diferentes modelos - Soporte de Markdown - Resumen de títulos de hilos de chat automáticos